इंटरनेट की सभी डरावनी शक्तियों में से, यह ट्रिकिंग करने की क्षमता है कि शायद सबसे भयावह हो। Clickbait, फोटोशॉप्ड तस्वीरें और झूठी खबरें सबसे खराब अपराधियों में से कुछ हैं, लेकिन हाल के वर्षों में एक नए संभावित खतरनाक उपकरण का उदय देखा गया है जिसे डीपफेक आर्टिफिशियल इंटेलिजेंस (एआई) के रूप में जाना जाता है।

डीपफेक शब्द का तात्पर्य नकली, कंप्यूटर जनित वीडियो और ऑडियो से है जो वास्तविक, अनछुए सामग्री से अलग होना कठिन है। यह फिल्माया गया है कि फ़ोटोशॉप छवियों के लिए क्या है।

AI कैसे काम करता है?

इस उपकरण पर निर्भर करता है कि जेनेरिक प्रतिकूल नेटवर्क (GANs) के रूप में जाना जाता है, 2014 में ईएन गुडफेलो, एक पीएच.डी. छात्र जो अब Apple में काम करता है, लोकप्रिय मैकेनिक्स ने बताया।

GAN एल्गोरिथ्म में दो अलग-अलग AI शामिल हैं, एक जो सामग्री उत्पन्न करता है - मान लीजिए, लोगों की तस्वीरें - और एक विरोधी जो यह अनुमान लगाने की कोशिश करता है कि चित्र वास्तविक हैं या नकली, वोक्स के अनुसार। जनरेटिंग एआई लगभग किसी भी विचार के साथ शुरू नहीं होता है कि लोग कैसे दिखते हैं, इसका अर्थ है कि इसका साथी आसानी से झूठे लोगों से सच्ची तस्वीरों को भेद सकता है। लेकिन समय के साथ, प्रत्येक प्रकार का एआई उत्तरोत्तर बेहतर होता जाता है, और अंततः उत्पन्न AI ऐसी सामग्री का उत्पादन करना शुरू कर देता है जो पूरी तरह से जीवन जैसा दिखता है।

गहन उदाहरण

गण प्रभावशाली उपकरण हैं और हमेशा दुर्भावनापूर्ण उद्देश्यों के लिए उपयोग नहीं किए जाते हैं। 2018 में, 17 वीं शताब्दी के रेम्ब्रांट वान रिजन जैसे कलाकारों की डच "ओल्ड मास्टर" शैली की नकल करने वाली एक गण-जनित पेंटिंग को क्रिस्टी के नीलामी घर में $ 432,500 में बेचा गया।

उसी वर्ष, डीपफेक व्यापक रूप से प्रमुखता के लिए बढ़े, मुख्य रूप से एक रेडिट उपयोगकर्ता के माध्यम से जो 'डीपफेक' नाम से गए, वाइस ने बताया। गैन तकनीक का इस्तेमाल अक्सर मशहूर हस्तियों के चेहरों को रखने के लिए किया जा रहा था, जिसमें गैल गैडोट, मैसी विलियम्स और टेलर स्विफ्ट शामिल हैं - अश्लील फिल्म अभिनेत्रियों के शरीर पर।

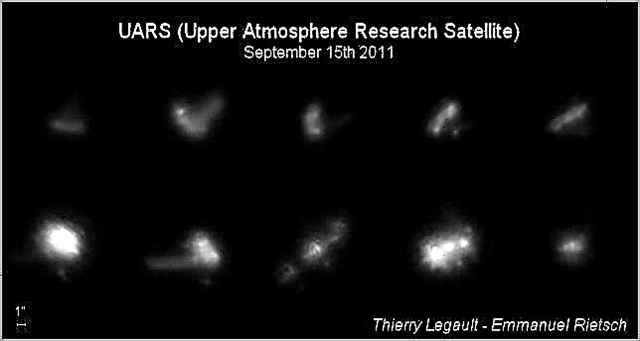

अन्य जीएएन ने किसी व्यक्ति की एकल छवि लेना सीख लिया है और उस व्यक्ति की काफी यथार्थवादी वैकल्पिक तस्वीरें या वीडियो बनाना चाहते हैं। 2019 में, एक डीपफेक मोना लिसा की खौफनाक लेकिन यथार्थवादी फिल्मों को उत्पन्न कर सकता है, विभिन्न पदों पर बात कर रहा है, हिल रहा है और मुस्कुरा रहा है।

डीपफेक ऑडियो कंटेंट को भी बदल सकते हैं। जैसा कि इस वर्ष की शुरुआत में द वर्ज ने बताया था कि तकनीक किसी व्यक्ति के बात करने के वीडियो में नए शब्दों को विभाजित कर सकती है, जिससे यह प्रतीत होता है कि उन्होंने कुछ ऐसा कहा है जिसका वे कभी इरादा नहीं करते थे।

जिस आसानी से नए टूल को तैनात किया जा सकता है, उसमें संभावित रूप से भयावह प्रभाव होते हैं। अगर कोई भी, कहीं भी यथार्थवादी फिल्में बना सकता है जो एक सेलिब्रिटी या राजनेता को दिखाते हुए बोल रहा है, चल रहा है और ऐसे शब्द कह रहा है जो उन्होंने कभी नहीं कहा, तो दर्शक इंटरनेट पर सामग्री से अधिक सावधान रहने के लिए मजबूर हो जाते हैं। एक उदाहरण के रूप में, राष्ट्रपति ओबामा ने फिल्म निर्माता जॉर्डन पील द्वारा डीपफेक का उपयोग करके बनाए गए बज़फीड के इस वीडियो में "अप-अप" डायस्टोपियन भविष्य के खिलाफ चेतावनी दी है।